[大衛選讀] 平常在開會或做設計討論時,我多半會打開筆記本,霹靂啪啦開始寫東西。有些設計師會問我,腦袋想就好,為什麼一定要打字?

這大概是研究所以後養成的習慣吧,一開始是為了把議題記錄下來,避免遺漏了而寫。後來慢慢演變成,只有三成記錄眼前脈絡,更多的是記錄腦袋裡的想法。

所以我的筆記除了聽到的重點之外,大部分會是我腦中的提問、可能的假設,以及後續的規劃與建議。有邊想邊記錄下來,思緒會變得很清晰,而且很快就能進入反思與決策。

生成式 AI 一鍵就可以錄音並且總結會議記錄,一開始用很驚艷,可是用著用著,我發現思考變慢變薄了,有一種腦霧感。

仔細想想,我的體感經驗完全呼應到 Paul Graham 所說的:寫作本身就是思考 (writing is thinking)。寫作本質上是一個擴充腦力、精鍊邏輯思維的過程,而不只是生成文字而已。

很快地,未來大量的寫作工作一定會被外包給 AI。但是思考跟語文能力的鍛鍊,想要讓腦袋變聰明,就更需要靠自己有意識地健身勞動了。

本文選讀彙整了多篇文章,內容整理如下,原文連結則放在留言中。

寫作就是思考,難以簡化,而且頗有壓力

Paul Graham 前一陣子寫了篇文章,名為《Writes and Write-Nots, 會寫作,與不寫作的人》。他認為,寫作本身就是思考 (writing is thinking)。寫作早已內嵌在許多工作中,而且工作的影響力越大,往往需要越多的寫作。

寫作本質上是件很困難的事,而且難以簡化。要寫得好,你必須思考清晰 (think clearly),而清晰地思考是件難事。

腦袋沒想清楚,寫得狗屁不通已經夠糟;如果還沒有深入思考,就去抄襲別人的文字,那就更慘了。字裡行間會顯露出瑣碎、平凡,而且缺乏洞見與思辨能力。

寫作,確實是件頗有壓力的事情。

一旦可以把寫作外包給 AI,人類將往兩個極端走

然而 AI 打開了一個新的可能性,生成式人工智慧一出現,幾乎所有寫作的壓力都已散去。無論是在學校還是工作中,幾乎都可以讓 AI 幫你代筆。

可清楚預見的,把寫作外包給 AI 的趨勢會加速發展。過往那個嘔心瀝血構思文句的繁重工作,一旦可以外包出去,那種一鍵生成快速便利的感覺,真是會令人感到興奮。

舉凡公司郵件、法律文件、伴娘致辭、訃文等,可預見的是,人工智能寫作將無處不在,要生成多少文字就有多少文字,甚至跟真人寫的沒什麼差別。

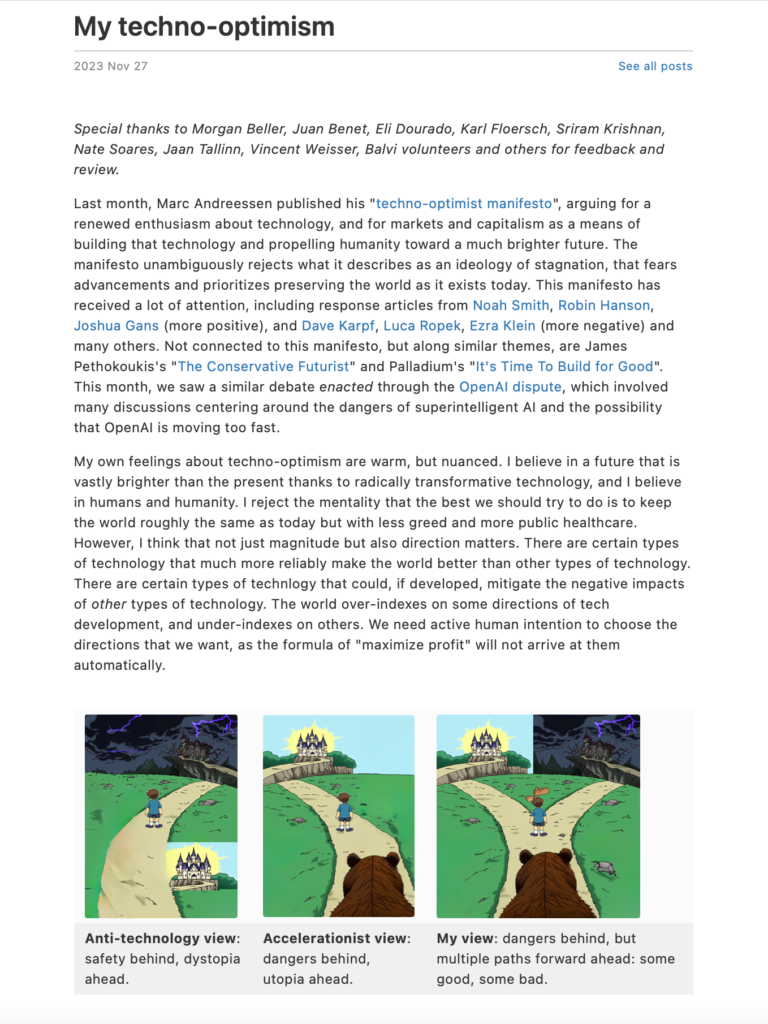

結果是,這個世界將分成兩群人:寫作者 & 非寫作者。喜歡寫作的人會變得更為優秀、更懂得思考;而其他人則會變得更加不擅長這些事情。

人工智能魔法的便利性,是有其代價的 (the convenience of AI magic comes at a cost)

AI 生成取代寫作,不僅是一種自動化的進程而已。這並不像是從算盤過渡到電子計算機那樣,只是計算上的勞力替代。讓人工智能為我們寫作的後果,實際上更加危險。

閱讀全文 當我們讓人工智慧代筆時,究竟失去了什麼?